Как защитить свой уникальный контент

Картинки, тексты и видео копировали, копируют и будут копировать. Предотвратить это не удастся ни одному владельцу сайта. Можно сыграть на опережение и попытаться защитить контент от кражи или же понадеяться на удачу и разбираться с плагиатором уже по факту воровства. Еще один вариант — не париться, ведь первоисточник якобы защищен от кражи, да и бороться с ветряными мельницами не всегда есть смысл. Вот только в последнем случае вам все равно придется разбираться с последствиями кражи контента.

В этой статьей вы найдете практичные советы, которые помогут вам защитить от плагиаторов свои тексты, картинки и видео. Но прежде давайте разберемся, какие проблемы могут возникнуть у сайта, если кто-то решит присвоить себе его контент.

Чем грозит копирование информации владельцу сайта?

- Потеря трафика. Возможно, после кражи на сайт копипастера уйдет часть ваших посетителей. В случае успешного ранжирования его позиция может оказаться выше, чем у вашего сайта. Дело в том, что поисковики не могут сразу определить первоисточник — соответственно, в выдаче отобразится несколько страниц с одинаковым контентом. Понижение позиций вызывает падение CTR — и как следствие уменьшается трафик на сайт первоисточника.

- Проседание позиций. Использование оригинальных текстов и картинок еще не гарантирует место в ТОПе. Вполне вероятно, некто скопировавший ваш текст окажется на первых местах в выдаче, а ваш сайт тем временем потеряет позиции.

- Ослабление лояльности читателей. Некоторые пользователи подумают, что это вы украли чужой контент. Их доверие к вашему сайту упадет, особенно если он менее популярный, моложе по возрасту или выглядит визуально хуже по сравнению с площадкой, на которую скопировали ваш контент.

- Санкции поисковиков. Да уж, неприятно, но порой фильтры от поисковых гигантов получают сайты-первоисточники — а копипастеры остаются безнаказанными, да еще и с ворованным контентом в придачу. Такое возможно, если поисковик неправильно определит первоисточник.

- Обновление информации на сайте. Если вам никак не удастся доказать факт воровства контента, придется обновлять тексты, картинки и видео на вашем сайте. А это дополнительные затраты времени и денег на специалистов.

Как понять, что контент своровали?

Если у вас появились подозрение, что ваш контент украли, проверить это можно несколькими способами:

- Через поисковую выдачу. Введите название статьи в поисковую строку и посмотрите, есть ли совпадения текста в выдаче.

- С помощью плагиатора картинок. Например, Tineye.

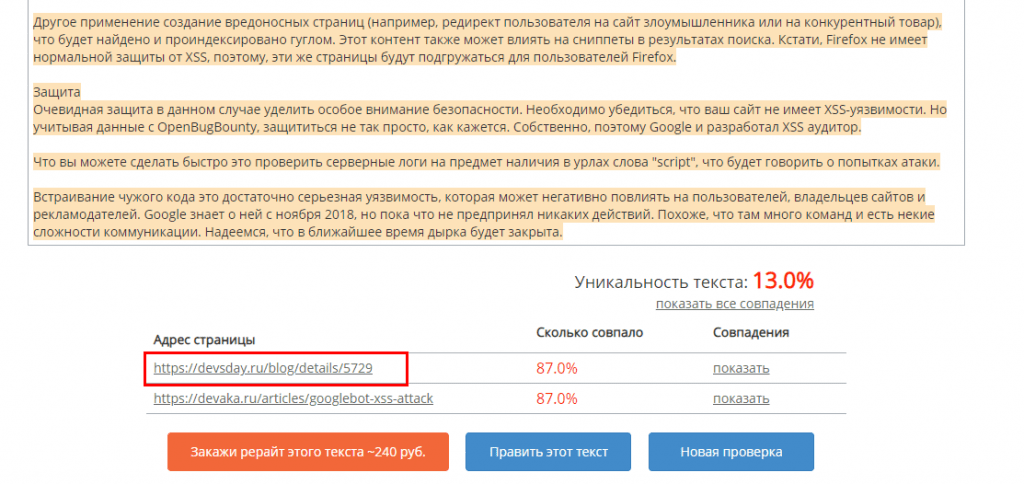

- В сервисах, которые проверяют тексты на уникальность. Например, Copyscape.com или Plagiarismchecker.co.

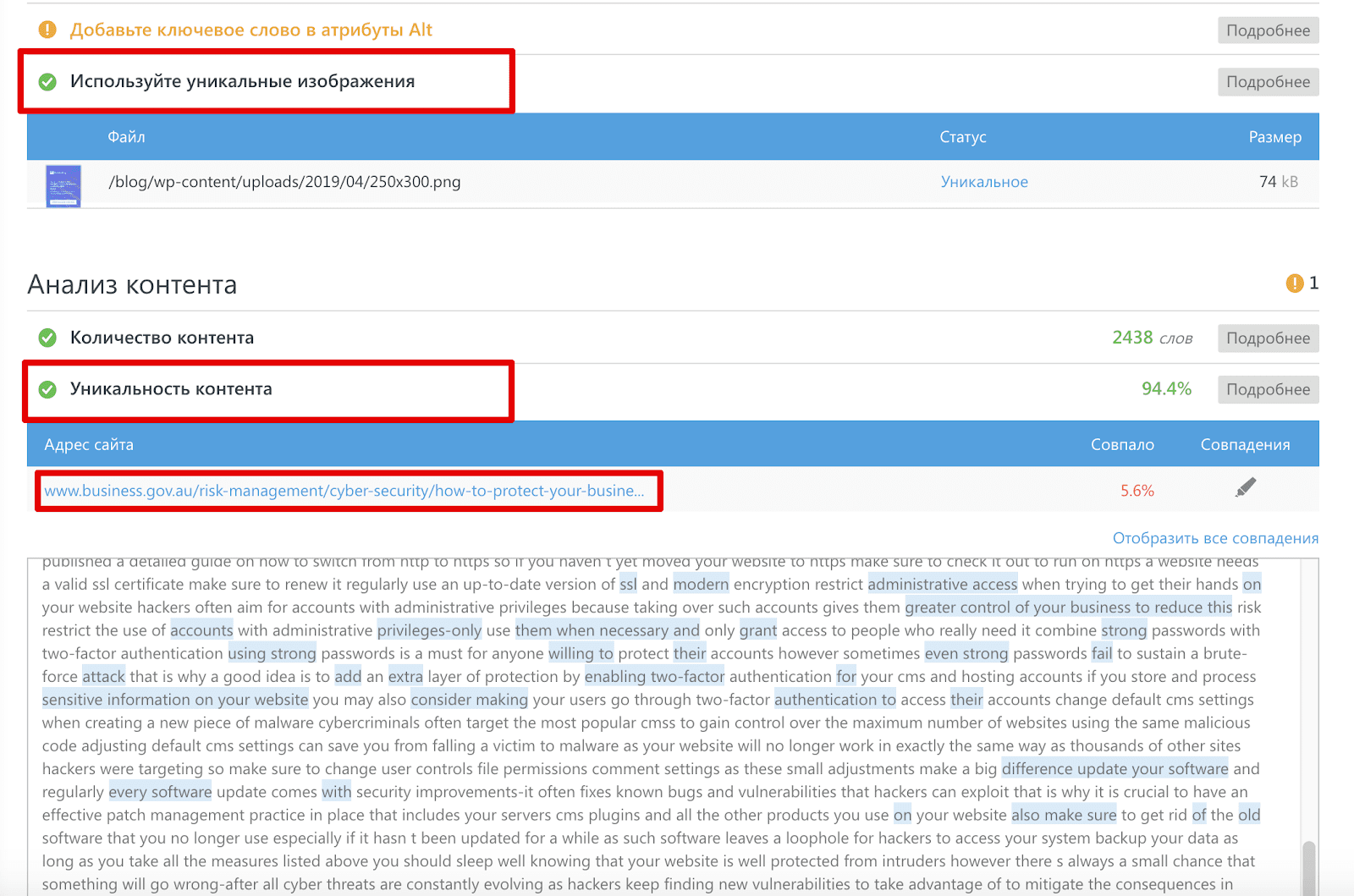

4. С помощью инструмента SE Ranking SEO-проверка страницы. Инструмент помогает оптимизировать страницу под целевой запрос, но с его помощью также можно проверить уникальность текста и изображений на странице.

Что делать, если контент украли?

На международном уровне защита прав первоисточников контента регламентируется Бернской Конвенцией и законом DMCA. Дополнительно права создателей контента защищены гражданским кодексом страны, в которой он зарегистрирован — причем эта протекция активируется сразу после публикации контента. На практике эти законы защищают лишь гипотетически, потому как многие их обходят. Поэтому первым делом при обнаружении плагиата советует обратиться к копипастеру напрямую.

Напишите в личном сообщении, что собираетесь довести дело до суда и что имеете доказательства принадлежности контента вам. Иногда это срабатывает — злоумышленник пугается и удаляет украденный текст. Если этого не произошло, попробуйте написать в техподдержку поисковиков. Это не всегда помогает, ведь при отсутствии весомых доказательств страницы с дублями контента из выдачи не уберут. Но переписка с техподдержкой поможет вам в суде, если до него дойдет.

Обращение в DMCA

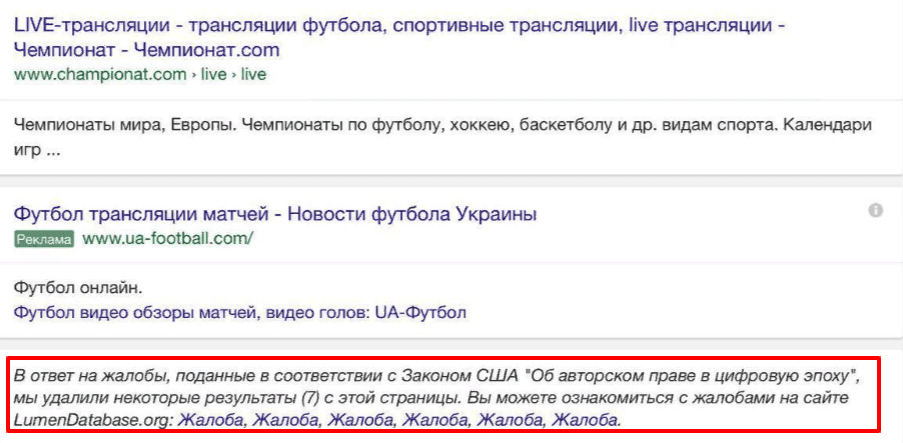

Вы можете подать уведомление о нарушении авторских прав согласно закону США «Об авторском праве в цифровую эпоху» либо встречную заявку, если такое уведомление было подано другим лицом на вас. При этом нужно предоставить все необходимые материалы для идентификации прав на опубликованный материал.

Как происходит обращение в DMCA:

- Автор подает заявку о нарушении авторских прав уполномоченному агенту сервис-провайдера («takedown notice») с просьбой удалить ворованный контент.

- Страница с копипастом удаляется из поиска, если сервис-агент зарегистрирован в U.S.Copyright Office.

- Владелец ресурса с копипастом получает уведомление об ограничении показа контента в связи с жалобой на нарушение прав в соответствии с DMCA.

Крайний случай — обращение в судебные органы. В этом случае будьте готовы к привлечению юриста и сбору весомых доказательств принадлежности контента именно вам.

Как защитить текстовый контент от кражи

Воспринимайте воровство текстов как комплимент. Если воруют, значит информация на вашем сайте полезная и востребованная. Но теперь вы знаете, что будущие текстовые посты придется защищать, так как плагиаторы могут украсть и их. Особенно это актуально для молодых сайтов, страницы которых ранжируются поисковиками не сразу. И если текст своруют на более популярный и крупный сайт — копипаст могут приписать вам.

Предлагаем способы защиты текста, которые сработают для ленивых или недостаточно компетентных копипастеров, а также помогут вам доказать свое авторство в суде.

1. Скрытый блок с информацией о скопированном тексте. Внутри текста вставляется фрагмент с упоминанием источника. Плагиатор скопирует и не заметит, что там упоминается название компании или сайта.

2. Создание отдельного CSS-стиля для запрета выделения текста. Например, noselect.

body{-webkit-user-select:none;-khtml-user-select:none;-moz-user-select:none;-ms-user-select:none;user-select:none;}

При отключении скриптов этот метод все равно будет работать. Но он не будет действителен, если потенциальный вор откроет код страницы и скопирует текст оттуда.

3. Использование Java-скрипта, который при копировании текста менял был часть символов с кириллицы на латиницу.

<script type="text/javascript">function addTrans(){var d=document.getElementsByTagName('body')[0];var e=window.getSelection();var c=e+"";var f="С с Е е Т О о р Р А а Н К Х х В М y З 3".split(/ +/g);var g="C c E e T O o p P A a H K X x B M у 3 З".split(/ +/g);var b;for(var b=0;b<f.length;b++){c=c.split(f[b]).join(g[b])}var a=document.createElement('div');a.style.position='absolute';a.style.left='-99999px';d.appendChild(a);a.innerHTML=c;e.selectAllChildren(a);window.setTimeout(function(){d.removeChild(a)},0)}document.oncopy=addTrans;</script>

Такой видоизмененный текст останется читабельным для людей, но не для поисковиков. Есть копипастер использует текстовый редактор с автоматической проверкой орфографии, он скорее всего заметит, что с текстом что-то не так, но вряд ли захочет тратить свое время на обратную замену символов.

4. Запрет на копирование в буфер обмена. Текст будет скопирован, но вставить его в буфер обмена злоумышленнику не удастся.

<body oncopy="return false">

5. Внутренняя перелинковка в тексте. Используйте внутри текста ссылки на другие страницы сайта. При копипасте текста ссылки тоже копируются и будут вести на ваш сайт.

6. Использование социальных сигналов. Добавьте возможность поделиться статьей, поставить ей лайк, добавить комментарии. Первую активность создавайте самостоятельно — так вы докажете авторство по дате, когда статьей поделились.

7. Использование пингаторов. Подключите функционал, которые автоматически будет рассылать сервисам сообщение о выходе публикации на вашем сайте. Например, FeedBurner Pingshot или PubSubHubBub. Можно использовать специальный плагин в WordPress либо привлечь программиста.

8. Отправка текстов на свою почту с указанием ссылки на публикацию. Это будет доказательством принадлежности текста вам.

9. Использование анонсов текстов на других ресурсах. Добавляйте новости о публикации на социальных порталах. Например, News2.ru.

10. Нотариальное заверение страниц сайта. Дорого, долго, зато эффективно на 100%.

Как защитить изображения от копирования

Возьмите на вооружение проверенные практики защиты своего визуального контента:

- Использование водяных знаков на изображениях. Создается при помощи Adobe Photoshop, Digimark, Watemark и подобных программ.

- Скачивание пустого файла или несуществующего формата. При скачивании картинка у плагиатора не откроется и он пойдет искать дальше.

- Запрет копирования через контекстное меню. Это делается через редактирование кода JavaScript, CSS, jQuery либо с помощью плагинов CMS.

- Цифровая метка на изображении. Информация о камере, дате, времени, локации — ваши доказательства прав на это изображение.

- Указание авторства через IPTC метаданные. Можно сделать в Adobe Photoshop, поддерживается в форматах JPEG и TIFF.

- Ссылочный анкор-лист из уникальных фрагментов текста объемом не более 100 символов. Такой способ ускоряет индексацию контента.

- Сбор картинки по частям. Режете изображение на куски, затем через код собираете его целиком. При скачивании копипастер получит лишь часть картинки.

- Использование лицензированных изображений. Поисковая система Google обрабатывает лицензии, в результате чего возле изображения появится соответствующий значок.

Как защитить видеоконтент от кражи

С картинками разобрались. А как быть с видео? Рекомендуем следующие методы:

- Использование водяного знака, идентификатора владельца — наиболее востребованный вариант, так как накладывает авторство даже при записи видео с экрана.

- Запрет для просмотра с разных устройств. В этом случае плеер привязывается к определенному устройству. Этот способ ограничивает в возможностях пользователей, которые должны смотреть видео на конкретном устройстве.

- AES-шифрование скачанного видео предотвращает его воспроизведение и защищает от продвинутых плагинов.

- Использование плеера, который закрывает ссылку для скачивания от пользователей и плагинов.

Методы, которые не работают для защиты контента от кражи

Вы могли слышать об этих методах, но знайте, что они не смогут предотвратить копирование контента.

- Использование аккаунта социальной сети Google+, который привязывали к сайту. Метод больше не работает, так как самой соцсети уже не существует.

- Использование встроенного скрипта для запрета копирования. Только ленивый копипастер не знает, что в этом случае достаточно открыть код страницы или отключить скрипты в браузере. А ленивый может погуглить и узнать.

- Ссылка на источник в конце текста. При вставке фрагмента текста курсор попадает в его конец, где и находится ссылка на источник. Ее невозможно пропустить мимо внимания, так что этот способ смело можно отнести к неэффективным.

Заключение

Полностью защитить контент от воровства не удастся, но это не значит, что не стоит пытаться обезопасить себя. Используйте один из предложенных способов защиты от копипаста — а лучше сразу несколько. Если же, несмотря на все меры предосторожности, плагиатор найдет способ скопировать ваш контент, напишите ему сразу по факту обнаружения. Сообщите злоумышленнику о наличии доказательств — в некоторых случаях это сработает. Если же плагиатор никак не отреагирует, обратитесь в техподдержку поисковиков. Последний вариант — сбор доказательств вашего авторства и обращение в суд.